Roberto1973

Power Member

A minha também não tem conectores PCI 5.

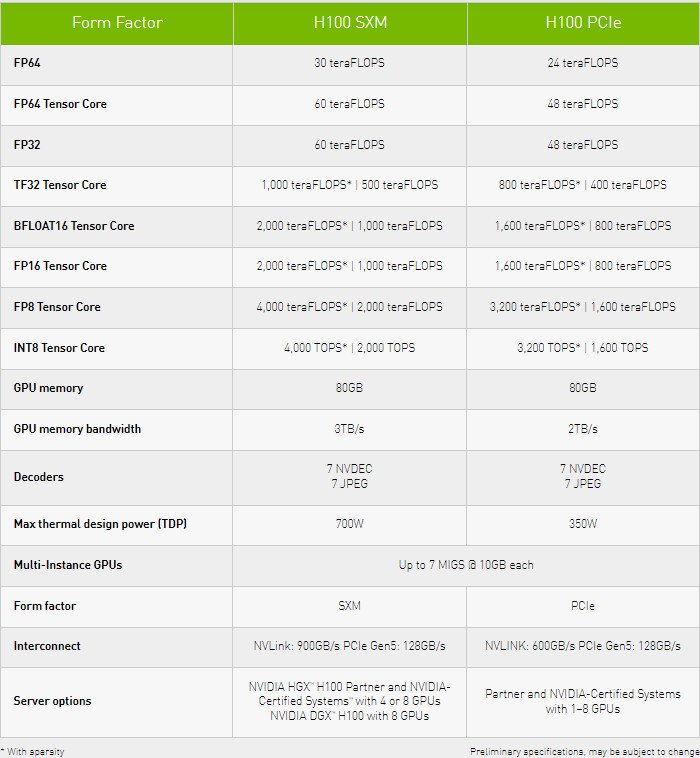

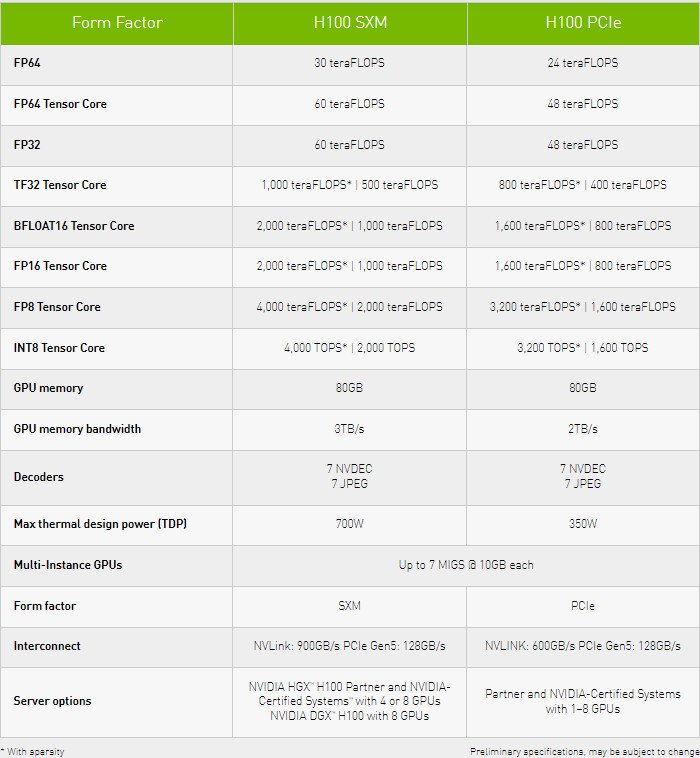

Então mantenho as minhas expectativas face a performance! Se não rondar perto do dobro da performance, apanhar com o dobro de consumo não será garantidamente uma boa jogada..A nVidia acabou de anunciar a H100 com 700W de TDP @ 1,78 Ghz TSMC 4nm. A anterior, a A100, tinha um TDP de 400W @ 1,41 Ghz TSMC 7 nm, com +/- a mesma área.

Esta H100 tem uma área gigante e a Lovelace "102" deve ter uma área mais pequena, mas esta H100 está a TSMC 4 nm e é provável que a Lovelace tenha Clocks mais elevados.

Na versão maior da Lovelace, numa "4090", não me parece que 600W de TDP seja uma surpresa. Talvez até acima disso em versões "OC".

A nVidia acabou de anunciar a H100 com 700W de TDP @ 1,78 Ghz TSMC 4nm.

É bastante menos potente que a versão SXM. O "truque" que a nVidia usa nessas specs, é usar números em "boost". O que não estão nessas specs é quanto tempo cada uma das versões aguenta em "boost" e quais são os valores quando não estão em "boost".A variante PCIe não é assim tão menos potente e só consome 350W.

As versões SXM não existem, nem são mais populares, por acaso.

As versões SXM não existem, nem são mais populares, por acaso.

Isso não faz sentido nenhum...Tudo o que não seja o dobro da performance (dado ao quase dobro do consumo) de uma 3090 vs 4090, será desilusão..

E diz-me uma geração em que a nova placa da mesma gama teve o dobro(+100%) da performance em rasterização do que a placa anterior?

Eu explico com um exemplo do mercado consumidor. O AMD 4800U e o 4800H têm os mesmos CPUs com 8 Cores, SMT, 8 MB de L3 e 4.2 Ghz. No GPU, o 4800U até tem mais 1 CU e mais 150 Mhz.Mas comparando com a A100 PCIe, consome apenas mais 50W, mas tem mais do dobro dos stream processors e mais do dobro dos TFlops em FP32, por exemplo.

Eu falei da A100 e da H100 porque temos um ponto de comparação dentro de processos de fabrico da TSMC. Dentro da mesma área, socket e com um pouco mais de clock, temos uma subida de TDP de 400W para 700W.Isso já me parece bem mais normal e o que poderá acontecer com as 4090. Até pode consumir um pouco mais que a 3090, mas se tiver mais do dobro da performance, o racio performance/watt melhora consideravelmente. O que é algo expectável quando passas de 8nm Samsung para 5nm TSMC.

Tflops =/= performance.A Gtx 1060 tem praticamente o dobro dos TFlops em FP32 em comparação com a Gtx 960 e ambas têm o mesmo TDP de 120 Watts.

Tflops =/= performance.

Nem a arquitetura pascal, que teve dos maiores saltos de performance geracionais dos últimos tempos, tinha o dobro da performance da gtx 960 em rasterização...

Mas a questão é que ao aumentarem o tdp desta forma se a performance não for bem perto de 2x superior algo estará errado.

Epa, eu tenho o mal de normalmente olhar para as gráficas primeiro a nível de trabalho e só depois para jogos, e como tal quando dou a minha opinião deveria explicar que quando falo em performance acaba por ser a nível de poder bruto, para renders, e afinsMas quando falam que a 4090 terá o dobro da performance da 3090, não me parece que estejam a referir em rasterização, mas sim em poder bruto, que depois acaba por nunca se concretizar no dobro da framerate em determinado jogo.

A 3090 tem 10496 stream processors e diz-se que a 4090 terá cerca de 18.000. Mais uns pozinhos no clock que os 5nm tsmc permitem e facilmente chega ao dobro do poder bruto. Isso claro, não se vai refletir na performance de um jogo, em que se a 3090 conseguir 4k 60fps, a 4090 não vai conseguir 4k 120fps.